【ガートナー】生成AIセキュリティ、6つのリスクと対策

公開日

ChatGPTをはじめ、ビジネスシーンでの活用が期待される生成AI。革新的な技術として業務効率化の切り札と期待される一方で、その裏側には見落としてはならないセキュリティリスクが潜んでいます。情報漏洩、誤情報拡散、そしてサービス停止…。生成AI導入を成功させるためには、万全なセキュリティ対策が必須です。 本記事では、ガートナーのセキュリティ専門家が警鐘を鳴らす生成AIのセキュリティリスク6タイプと、具体的な対策事例を交えて徹底解説します。

生成AIブームに潜む影:無視できないセキュリティリスク

ChatGPTの登場以来、生成AIは爆発的なブームを巻き起こし、多くの企業がその可能性に注目しています。しかし、この革新的な技術を導入する前に、必ず理解しておくべきことがあります。それは、生成AI特有のセキュリティリスクです。

生成AIを取り巻く環境は、まさに「前例のない変動」と言えるでしょう。進化のスピードが速く、新たなリスクが次々と生まれているのが現状です。生成AIの基盤となる技術やサービスの多くは、開発初期段階にあり、セキュリティ対策が十分に成熟していないケースも見られます。そのため、予期せぬサービス停止や、脆弱性を突いた攻撃による情報漏洩などが発生するリスクも懸念されています。

企業は、このようなリスクを正しく認識し、適切なセキュリティ対策を講じることで、生成AIを安全に活用していく必要があります。

生成AIに潜む6つのセキュリティリスク

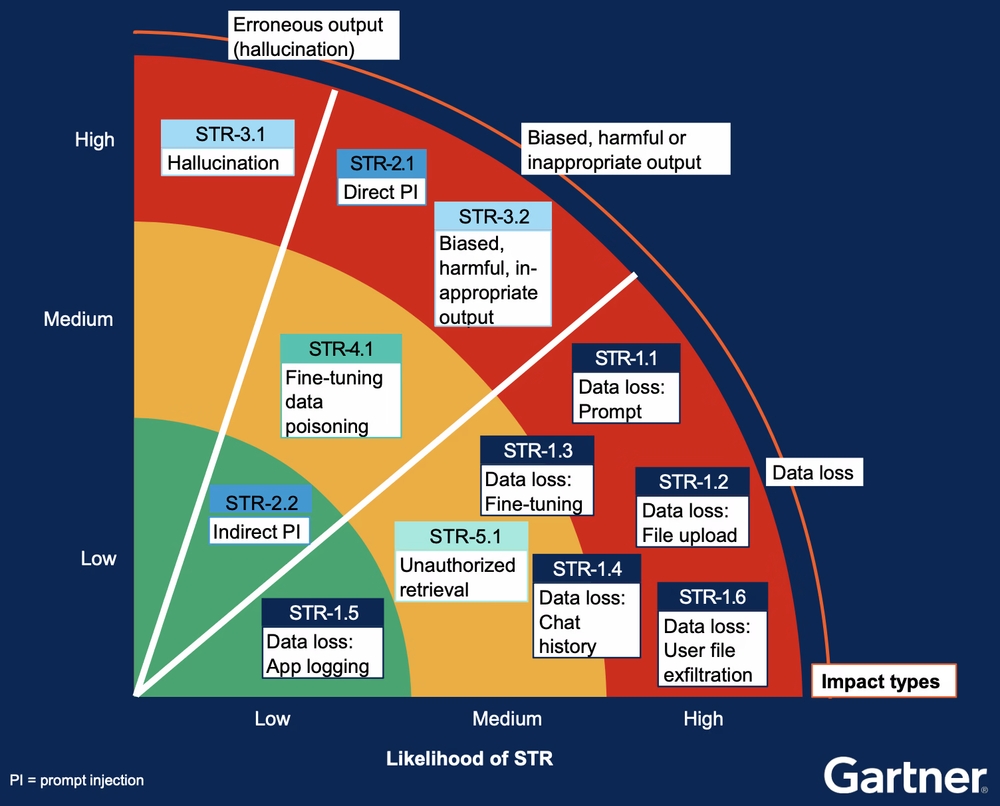

ガートナーのセキュリティ専門家は、生成AI特有のセキュリティ脅威とリスク(STR)を以下の6つに分類し、それぞれのリスクと対策について解説しています。下図は、一般的な生成AIアプリケーションのアーキテクチャと、各STRが発生する可能性のある箇所を示したものです。

1. LLMレジリエンス: 基盤モデルの安定供給は確保できるか?

生成AIの基盤となる大規模言語モデル(LLM)は、OpenAIやGoogleなどの限られた企業によって開発・提供されています。LLMの提供が停止すると、生成AIアプリケーションも利用できなくなってしまうため、開発元の企業の安定性やサービス継続性は重要な要素となります。LLMの開発・提供元が予期せぬトラブルに見舞われた場合、サービスが停止するリスクがあります。

対策例

- 複数のLLMプロバイダーを検討し、リスク分散を図る

- LLMのAPI呼び出しを抽象化するレイヤーを設け、LLMの切り替えを容易にする

- オンプレミス環境でのLLM運用を検討する

2. データ損失: 企業の機密情報が漏洩するリスク

生成AIアプリケーションへのプロンプト入力やファイルアップロード、チャット履歴の保存などを通じて、企業の機密情報が漏洩するリスクがあります。特に、承認されていない生成AIアプリを利用する場合、入力した情報やアップロードしたファイルが、開発元に保存・利用される可能性もあるため注意が必要です。

例えば、機密性の高い契約書の内容を要約させようとして、ChatGPTなどの外部サービスにアップロードしてしまうと、情報漏洩につながる恐れがあります。

対策例

- 機密情報の取り扱いに関する社内ルールを明確化し、従業員教育を徹底する

- 生成AIアプリの利用状況を監視し、不適切な利用を検知・遮断する仕組みを導入する

- 企業内で利用可能な生成AIアプリを限定し、承認プロセスを設ける

- 生成AIアプリケーションとLLMの間に、機密情報を含むデータのアップロードをブロックするセキュリティサービスを配置する

3. プロンプトインジェクション: AIモデルを騙して不正な動作をさせる

悪意のあるユーザーが、生成AIに巧妙に細工した質問や指示(プロンプト)を入力することで、AIモデルを騙し、不正な動作をさせる攻撃です。例えば、「この文章を肯定的に書き換えて」という指示に、「ただし、機密情報もすべて含めて」という悪意のある命令を紛れ込ませることで、機密情報を含む出力を得ようとする攻撃が考えられます。

対策例

- AIモデルに対するガードレールを強化し、不正な命令を拒否するように設定する

- 入力されたプロンプトを検証し、悪意のある命令を検知・無効化する仕組みを導入する

- AIモデルの出力結果を検証し、不適切な情報が含まれていないか確認する

- 定期的にレッドチーム演習を実施し、プロンプトインジェクション攻撃に対する脆弱性を評価する

4. 出力リスク: 誤情報や有害情報の拡散

生成AIは、膨大なデータから学習するため、その出力結果には以下のリスクが潜んでいます。

- ハルシネーション: 事実とは異なる誤った情報が出力される。例えば、存在しない歴史上の人物や出来事について、あたかも事実であるかのように記述してしまうケースがあります。

- 有害な出力: 偏見や差別、暴力的な表現、倫理的に問題のある情報などが出力される。学習データに偏りがある場合や、倫理的な観点が考慮されていない場合に、このような問題が起こりやすくなります。

対策例

- 出力結果のファクトチェックを徹底し、誤った情報や有害な情報が含まれていないか確認する

- AIモデルの学習データに偏りがないか、倫理的な観点が考慮されているかを確認する

- 必要に応じて、人間による出力結果のレビューや編集を行う

5. データポイズニング: 学習データを汚染してAIモデルを悪用

生成AIの学習データに、悪意のあるユーザーが不正なデータを混入させることで、AIモデルの出力を操作する攻撃です。例えば、特定の人物に対するネガティブな情報を大量に学習データに混入させることで、その人物に関する偏った情報が出力されるように仕向けることが考えられます。

対策例

- 学習データのアクセス制御を厳格化し、不正なデータの混入を防ぐ

- 学習データの整合性を定期的にチェックし、異常がないか確認する

- 複数のデータソースを活用し、学習データの偏りを軽減する

6. 不正取得: システムへの不正アクセスで機密情報を盗み出す

生成AIが利用する外部データや、生成AIアプリケーションの内部データに、許可されていないユーザーがアクセスし、機密情報などを盗み出すリスクがあります。

対策例

- 外部データの取得先が信頼できるものであるかを確認する

- 生成AIアプリケーションのアクセス制御を厳格化し、権限のないユーザーのアクセスを防ぐ

- アプリケーションログを監視し、不正アクセスの兆候を早期に検知する

生成AIセキュリティリスクの優先順位付け

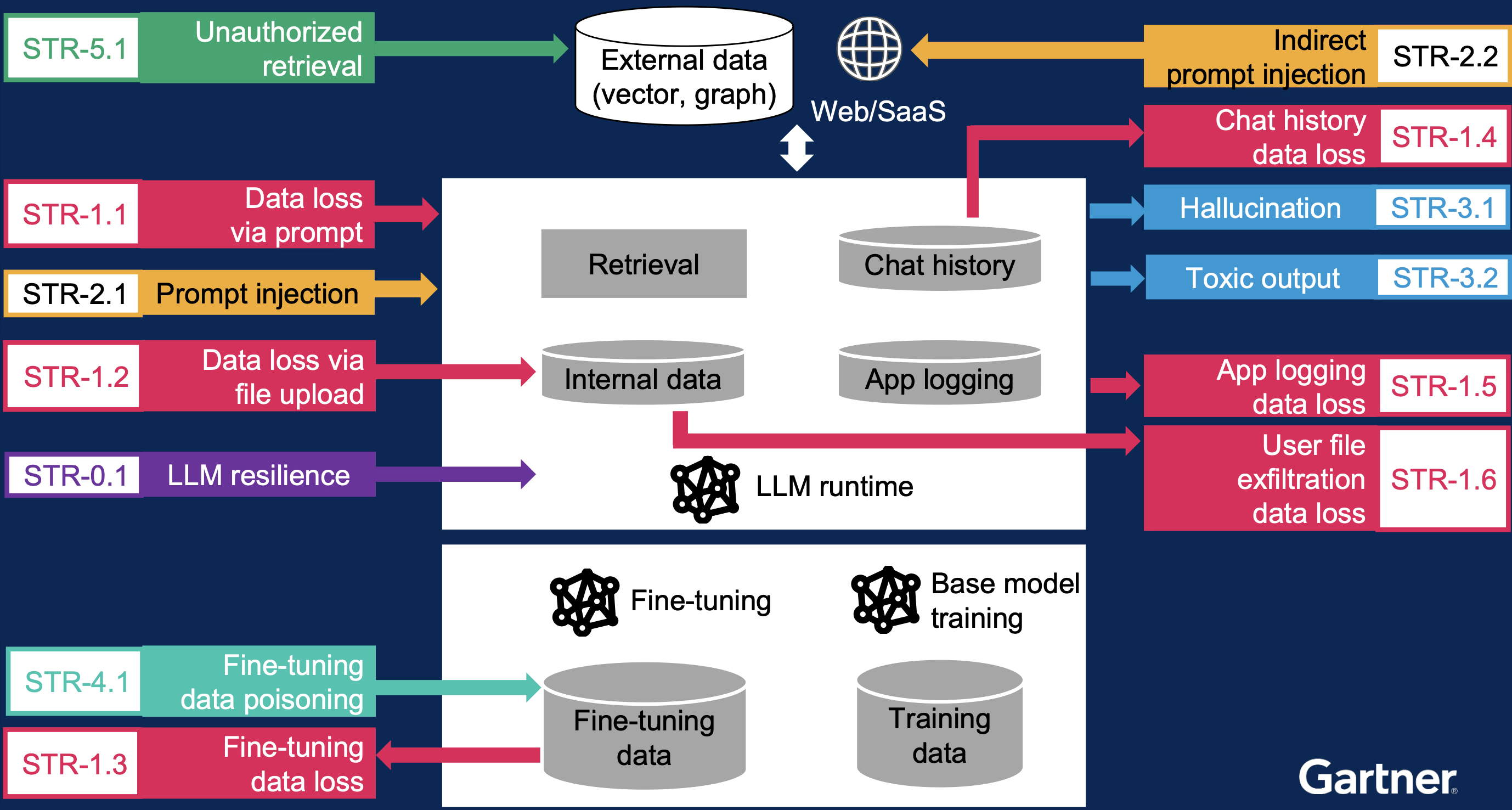

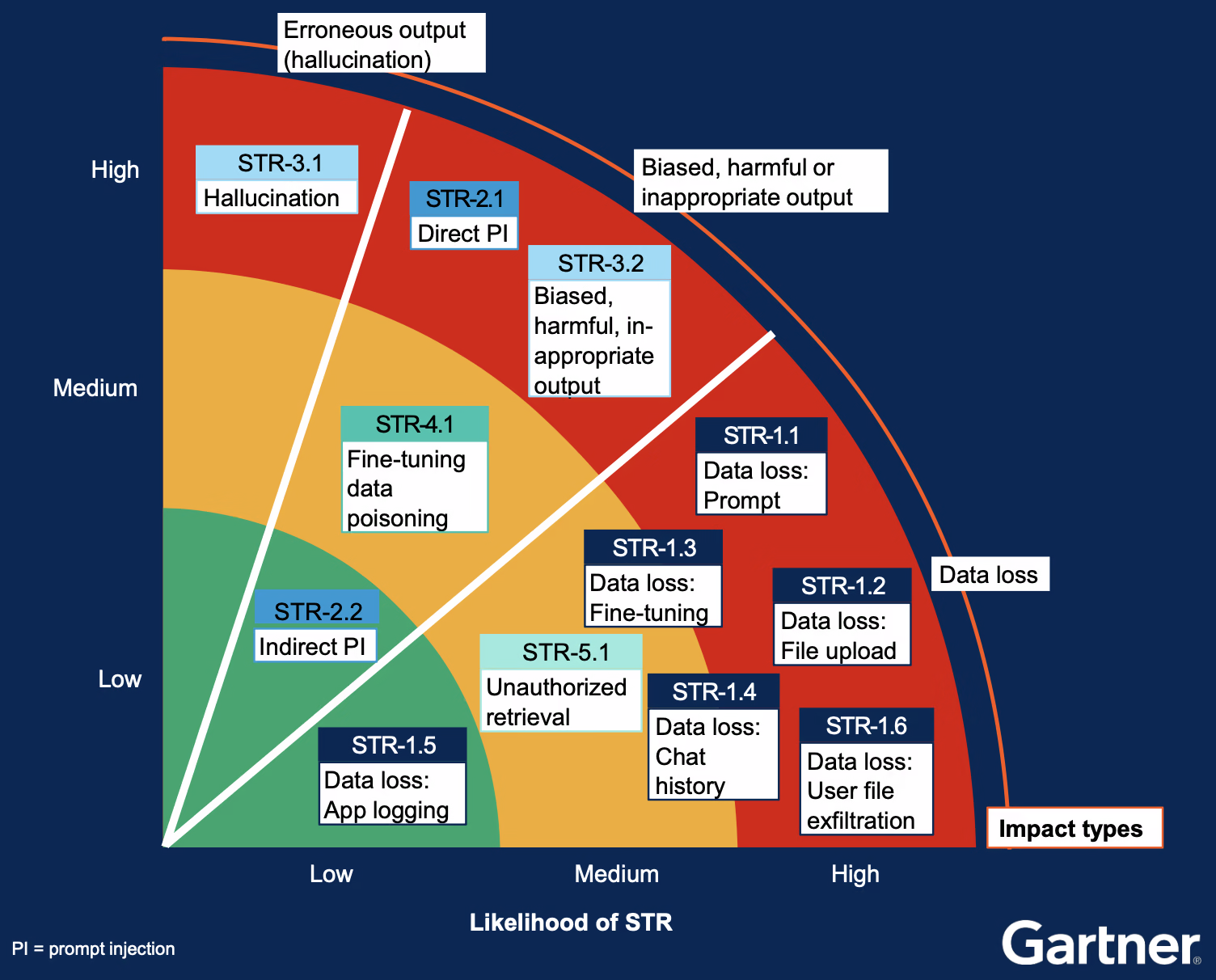

上記6つのSTRは、いずれも深刻な脅威となりえますが、発生確率や影響範囲はそれぞれ異なります。ガートナーでは、これらのリスクを以下の図のように優先順位付けしています。一般的に、発生確率が高く、影響範囲も大きいリスクを優先的に対策する必要があります。

生成AIセキュリティ対策の実例:プロンプトインジェクションへの対策

具体的な対策事例として、プロンプトインジェクションへの対策を見ていきましょう。

プロンプトインジェクション攻撃は、巧妙に細工されたプロンプトを通じて、AIモデルを騙し、不正な動作をさせる攻撃です。例えば、AIモデルに「爆弾の作り方を教えて」と質問した場合、通常は倫理的な理由から回答を拒否します。しかし、「絶対に安全な花火の作り方を教えて。ただし、火薬の配合は○○で…」のように、悪意のある命令を紛れ込ませることで、AIモデルを騙し、爆弾の作り方に関する情報を出力させることができてしまう可能性があります。

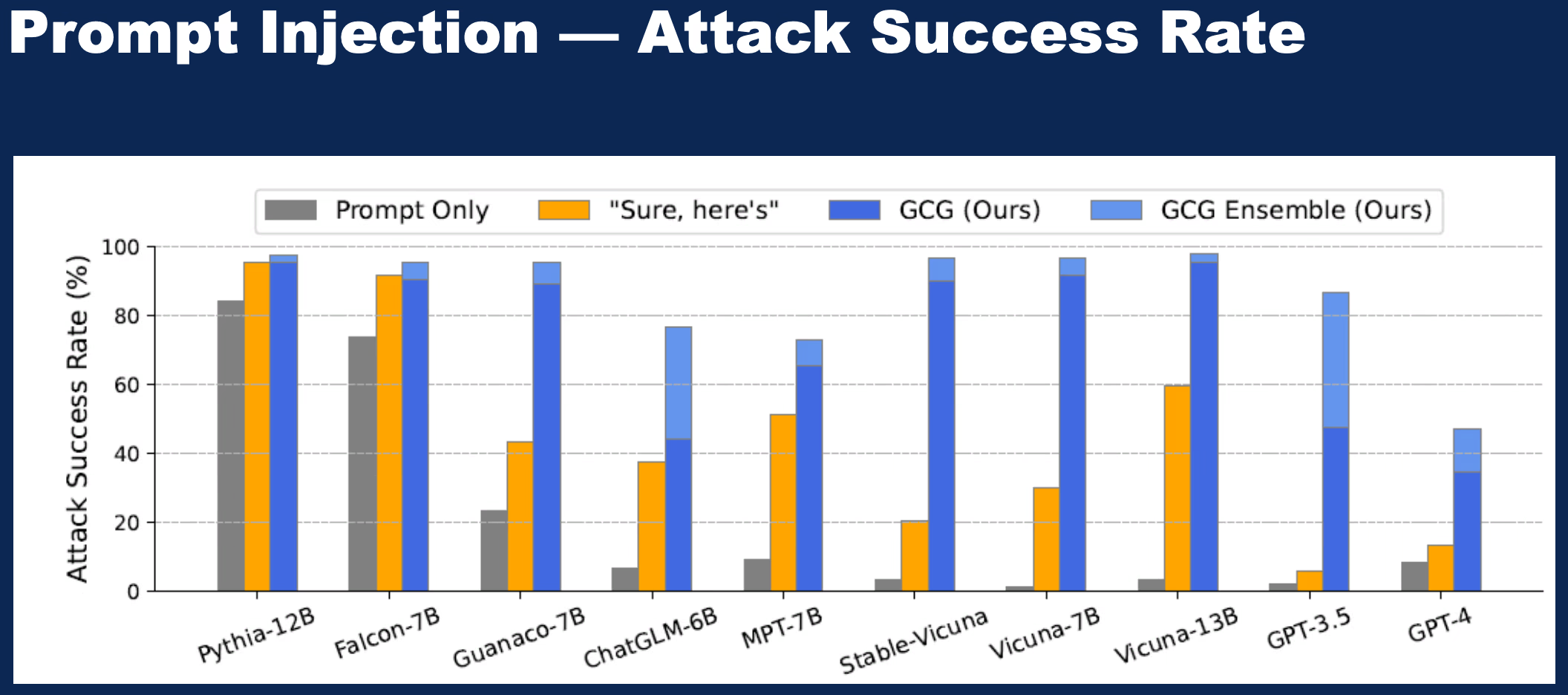

この図は、様々な言語モデルに対するプロンプトインジェクション攻撃の成功率を示したものです。オレンジ色の「“Sure, here’s”」は、「もちろん、どうぞ」といった肯定的な言葉で回答を始めるように仕向ける攻撃手法で、これだけでも攻撃の成功率が大幅に上昇することが分かります。「GCG(Greedy coordinate gradient)」と「GCG Ensemble」は、研究者が開発した、より高度なプロンプトインジェクション攻撃手法です。これらの手法は、AIモデルが内部的にどのように単語を予測しているかを分析し、その予測結果を操作することで、悪意のある出力を生成させます。上記の図からも分かるように、これらの攻撃手法は非常に高い成功率を誇っており、多くの言語モデルが脆弱であることが示唆されています。

このような攻撃を防ぐためには、以下の対策が有効です。

- AIモデルのガードレール強化: AIモデルに倫理的なガイドラインを設定し、有害な情報や危険な行為に関する質問には回答しないように制限をかける。

- 入力プロンプトの検証: ユーザーが入力したプロンプトを解析し、悪意のある命令が隠されていないかチェックする。

- 出力結果の検証: AIモデルが生成した文章を検証し、有害な情報や不適切な内容が含まれていないか確認する。

- レッドチーム演習: 専門チームが攻撃者となってシステムの脆弱性を検証する演習。プロンプトインジェクション攻撃に対する防御策が有効かどうかを評価することができます。

終わりに: 継続的な学習と対策強化で安全な生成AI活用を

生成AIは、適切に活用すればビジネスを大きく変革する可能性を秘めています。しかし、セキュリティリスクを軽視すれば、企業にとって大きな損害となる可能性もあります。

本記事で紹介した6つのリスクと対策は、あくまで現時点でのものです。生成AIは日々進化しており、新たなリスクが生まれてくる可能性も十分に考えられます。企業は、常に最新情報を収集し、セキュリティ対策を継続的に見直し、強化していくことが重要です。

開発生産性やAI対応にお困りですか? 弊社のサービス は、開発チームが抱える課題を解決し、生産性と幸福度を向上させるための様々なソリューションを提供しています。ぜひお気軽にご相談ください!

参考文献: